Google Search Console – Die wichtigsten Funktionen für SEO nutzen

Im ersten Teil dieses Artikels habe ich die verschiedenen Möglichkeiten zur Einrichtung der Google Search Console gezeigt, und auf was man dabei achten sollte. In diesem Teil schauen wir uns die wichtigsten Funktionen der Google Search Console an und wie man diese als SEO nutzen kann.

Für SEOs ist die GSC eines der wichtigsten SEO Tools überhaupt. Neben der Tatsache, dass die GSC kostenlos ist, stammen die Daten außerdem direkt von Google und bieten somit ein unschlagbares Preis- Leistungsverhältnis. Schauen wir uns die wichtigsten Funktionen, die man als SEO kennen sollte, genauer an.

Strukturierte Daten

Die Auszeichnung strukturierter Daten mittels Schema.org oder auch der Einsatz von Microdaten, RDFa und Mikroformaten hilft Google dabei, Daten besser zu verstehen und wird zum Teil mit einer gesonderten Darstellung belohnt, was zu einer Steigerung der CTR führen kann.

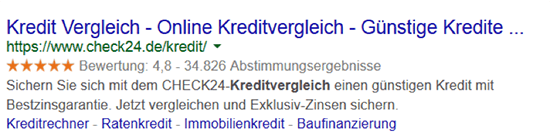

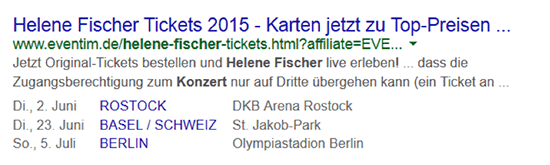

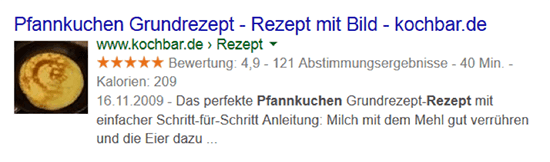

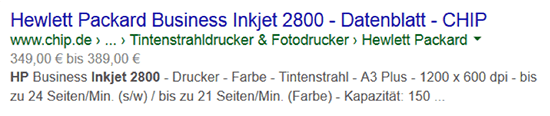

Hier eine Liste der bekanntesten Rich Snippets in den deutschen Suchergebnissen

Abbildung 1: Breadcrumb Navigation wird anstelle der URL dargestellt

Abbildung 2: Bewertungen werden mit Sternchen dargestellt

Abbildung 3: Das Datum und Ort von Veranstaltungen/Events als Listenansicht

Abbildung 4: Rezepte mit Bilder, Kochzeit und Kalorien

Abbildung 5: Preisspanne bei Produkten

Weitere Informationen zu den Rich Snippets, liefert Google Developers. Seitenbetreiber sollten sich auch die Richtlinien genau anschauen, denn Google geht bei massiven Manipulationsversuchen hart gegen diese vor.

Unter dem Menüpunkt Strukturierte Daten listet Google fehlende oder fehlerhafte Markups auf.

Abbildung 6: Anzahl der gefunden Markup Fehlern über die Zeit

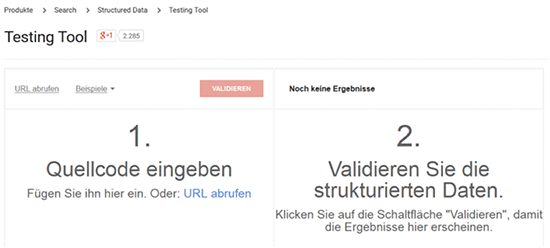

Die hier von Google aufgelisteten Fehler, sollte man immer genau überprüfen, da Google auch Fehler auflistet, die für die Webseite keine Bedeutung haben. Um auf Nummer sicher zu gehen, sollte man daher das Structure Data Testing Tool nutzen, bei dem ihr die zu testende URL einfach eingeben könnt. Für Seiten, die noch nicht live sind, kann man auch den HTML Code eingeben.

Abbildung 7: Google Structure Data Testing Tool

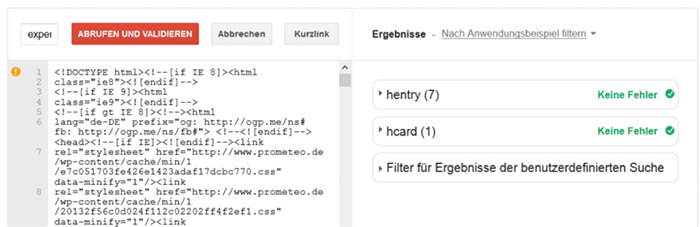

Als Ergebnis liefert Google wertvolle Informationen wie gefundenen Fehler oder auch welche Daten ausgelesen werden.

Abbildung 8: Keine Fehler in den Markups

Randnotiz: Aus SEO Sicht macht die Auszeichnung von Strukturierten Daten durchaus Sinn, schließlich kann man damit den organischen Traffic auf der eigenen Webseite steigern. Aber die Nutzung kann auch Probleme mit sich bringen. Durch die Auszeichnungen von Produktpreisen, Namen usw. haben es Scraper noch einfacher, da die Daten in einer strukturierten Form vorliegen und somit nur noch abgerufen werden müssen.

Ein zweiter Kritikpunkt zur Nutzung von Markups: Google. Google testet und dringt ständig in neue Business Bereiche vor. Durch die gesammelten Daten hat Google für viele Bereiche bereits die notwendige Datenbasis. Man sollte sich daher immer gut überlegen, was wichtiger ist: der Google Traffic oder die Gefahr das jemand seine Daten übernimmt.

Suchanfragen

Der Anteil der "not provided" Daten in Statistik Tools wie Google Analytics ist inzwischen so groß, dass die angezeigten Suchbegriffe kaum noch eine Aussagekraft haben. Zum Glück gibt es die Suchanfragen in der Google Search Console. Der Webmaster erhält hier nicht nur eine Liste an Suchbegriffen, sondern auch weitere Informationen:

Wie oft die Domain in den Google Suchergebnissen dargestellt worden ist (Impressionen)

Wie häufig geklickt wurde (Klicks)

Wie hoch das Verhältnis zwischen Impressionen und Klicks ist (CTR)

Auf welcher Position die Domain in den Suchergebnissen gefunden wurde (Durchschn. Position)

Viele nützliche Informationen, die man mit ein paar einfachen Tricks noch effizienter gestalten kann.

Mehr Keywords mit dem Filter

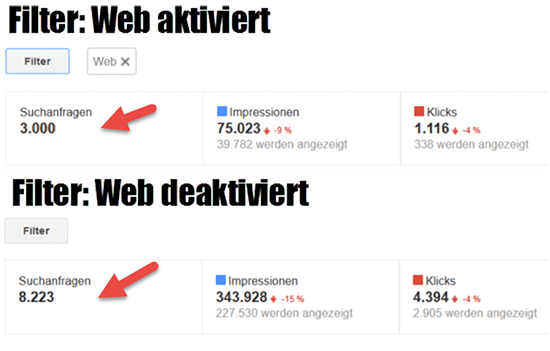

Der Filter in den Suchanfragen bei der Google Search Console steht standardgemäß auf Web. Wenn man diesen deaktiviert, erhält man mehr Daten:

Abbildung 9: Löscht man den „Web“ Filter, erhält man mehr Suchanfragen

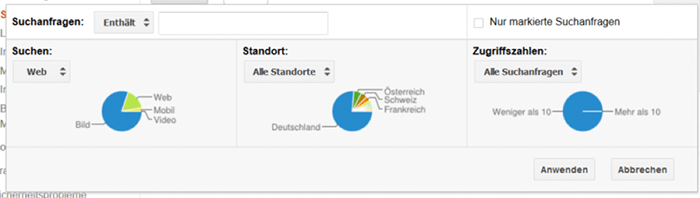

Wie man in diesem Beispiel sehen kann, werden aus den 3.000 Suchbegriffen 8.223, die man alle exportieren kann. Die Filter haben auch einen anderen Nutzen, so können sich Bilder-SEOs zum Beispiel Suchbegriffe nur für die Bildersuche ausgeben lassen. Gleiches gilt auch für Mobile, Video, Standorte oder auch Suchanfragen ab einem bestimmten Anfragevolumen.

Abbildung 10: Die Filter in den GSC Suchanfragen

Verzeichnisse anmelden

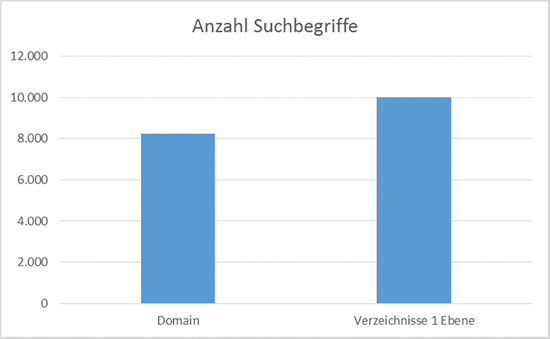

Ein weiterer Trick für mehr Suchbegriffe in der GSC ist die Anmeldung von allen Unterverzeichnissen anstatt nur einer Domain.

Abbildung 11: Angemeldete Verzeichnisse eines WordPress Blogs

Stellt man die Anzahl der Suchbegriffe aus den Verzeichnissen den der Hauptdomain gegenüber, werden auf diese Weise im Schnitt 20% mehr Suchbegriffe angezeigt.

Abbildung 12: Vergleich der gefundenen Suchbegriffe Root Verzeichnis vs. Verzeichnis der 1. Ebene

Wer über genügend Programmierskills verfügt, kann die Anmeldung auch über die Google Search Console API abwickeln und so alle Verzeichnis automatisiert anmelden.

URL Keyword Matching

Als es noch möglich war Suchbegriffe über Google in Google Analytics & Co zu erhalten, war es sehr wichtig zu sehen, auf welcher Landingpage ein User mit einem Suchbegriff gelandet ist. Die Funktion Häufigste Suchanfrage liefert dazu leider keine Information, welche URL nun mit dem Suchbegriffe gefunden worden ist. Eine Möglichkeit dies herauszufinden, wäre es, die Suchbegriffe mit einem Ranking Tool abzufragen. Oft ist dies aber aufgrund der Menge nicht möglich.

Sehr praktisch ist dabei der Menüpunkt Häufigste Seiten. Hier listet Google, wie der Name schon sagt, die am häufigsten aufgerufenen Seiten auf. Je nach Wichtigkeit einer URL, erweitert Google hier die Daten sogar mit den passenden Suchbegriffen, was durch einen kleinen schwarzen Pfeil vor der URL erkennbar ist. Klick man auf diesen erhält man eine Liste an Suchbegriffen:

Abbildung 13: Suchbegriffe für eine URL

Leider befinden sich die Suchbegriffe nicht im Export dieser Liste. Wer also erfahren möchte, mit welchem Suchbegriff eine URL gefunden worden ist, erhält diese Information nur manuell.

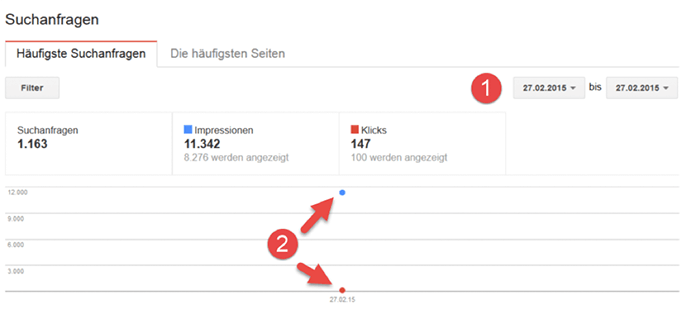

Ranking Position auf Tagesbasis

In den Suchanfragen liefert uns Google auch die durchschnittliche Ranking Position. Um hier einen möglichst genauen Wert zu erhalten, kann man den Zeitraum auf einen Tag reduzieren. Aber Achtung: Die jüngsten Daten, die man erhalten kann, sind mindestens 3 Tage alt.

Abbildung 14: Suchanfragen auf Tagesbasis

Obwohl es sich bei den Rankingpositionen um einen Durchschnittswert handelt, ist die Datenqualität doch überraschend gut und kann daher auch für ein Reporting genutzt werden. Exportiert man diese Daten oder nutzt die GSC API kann man so sich so seinen eigenen Rankingverlauf auf Keywordbasis zusammenbauen.

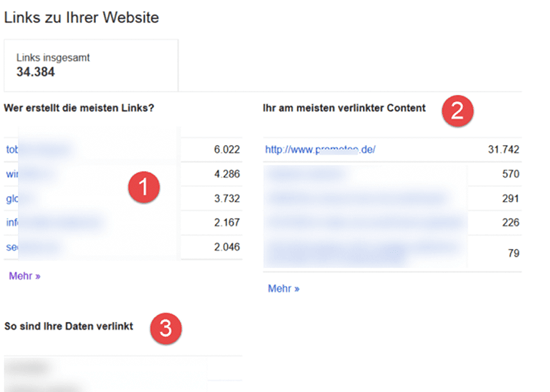

Links zu Ihrer Webseite

Auch wenn es erste Experimente gibt, einen Suchmaschinenalgorithmus ohne Backlinks zu bauen, bei Google zählen sie immer noch. Unter dem Menüpunkt Links zu Ihrer Webseite findet man Backlinks gruppiert nach:

Verlinkende Domain

Am häufigsten verlinkte URL

Die am häufigsten verwendeten Anchor-Texte

Abbildung 15: Backlink Daten in der Google Search Console

Leider ist Google bei der Bereitstellung der Daten nicht gerade schnell und sagt selbst, dass die Daten nicht so vollständig sind, um zum Beispiel bei einem Reconsideration Request als Backlink Datenquelle zu gelten. Wer also vollständige und aktuelle Backlinkdaten haben will, sollte sich die Daten aus verschiedenen SEO Tools selbst aggregieren. Trotzdem sollte man als SEO immer in diesen Bericht reinschauen und eventuelle Auffälligkeiten besser kontrollieren.

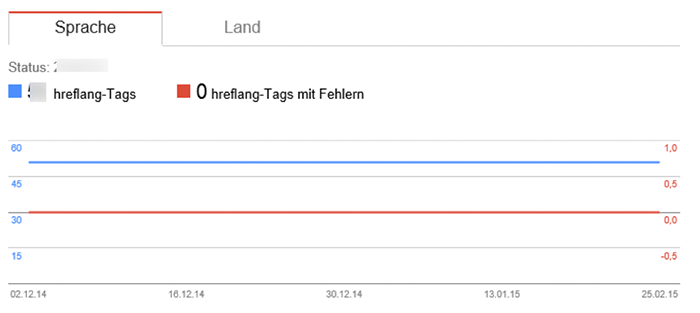

Internationale Ausrichtung

Über die internationale Ausrichtung kann man eine nicht länderspezifische Domain, wie zum Beispiel .com, .org, .net einem Land zuordnen. Betreibt man zum Beispiel eine Seite mit domain.net, dessen Inhalt aber nur für Deutschland interessant ist, kann man dies Google auf diese Art mitteilen.

Eine weitere Möglichkeit ist die Verwendung des hreflang Tags, mit dessen Hilfe man auf URL-Ebene Zielland und -Sprache definieren kann. Gerade für internationale Seiten ist es daher wichtig, Google keine Zweifel daran zu lassen, für welche Sprache und welches Land eine URL gemeint ist. Schließlich kann es sich negativ auf die User-Signale auswirken, wenn Inhalte für Deutschland in Österreich oder andersrum auftauchen und dadurch langfristig Rankingverluste in Kauf genommen werden. Als SEO sollte man daher in regelmäßigen Abständen prüfen, ob Google Fehler bei der Verwendung des hreflang-Tags gefunden hat. Denn eine falsche Zuordnung bei einem Online-Shop der in DACH aktiv ist, kann ein nicht existierender oder fehlerhafte hreflang-Tag schlimme Konsequenzen mit sich bringen.

Abbildung 16: Analysierte hreflang-Tags in der GSC

Wer mehr über das optimale Setup internationaler Webseiten erfahren will, sollte sich den Artikel Go Global or Go Home – Language Targeting durchlesen.

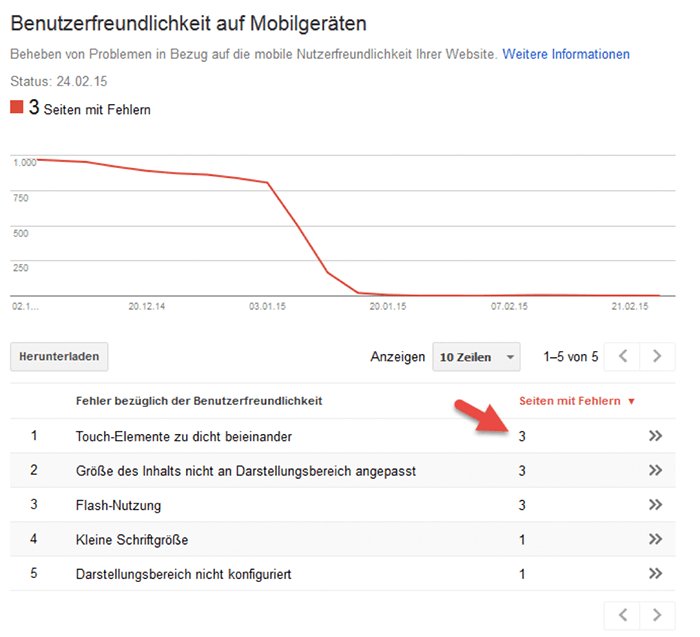

Benutzerfreundlichkeit auf Mobilgeräten

Anfang 2015 hat Google begonnen, Webmaster intensiv darüber zu informieren, dass ihre Seiten für die Darstellung auf mobilen Geräten wie Smartphones, nicht geeignet sind. Daraufhin gab es Vermutungen, dass dies auch bald ein Ranking Faktor sein könnte. Dies wurde anschließend nicht nur von Google bestätigt, sondern es gab sogar ein konkretes Update.

Unter diesem Menüpunkt liefert Google eine Übersicht der Fehler und der dazugehörigen URLs auf:

Abbildung 17: Typische Fehler bei Mobilgeräten

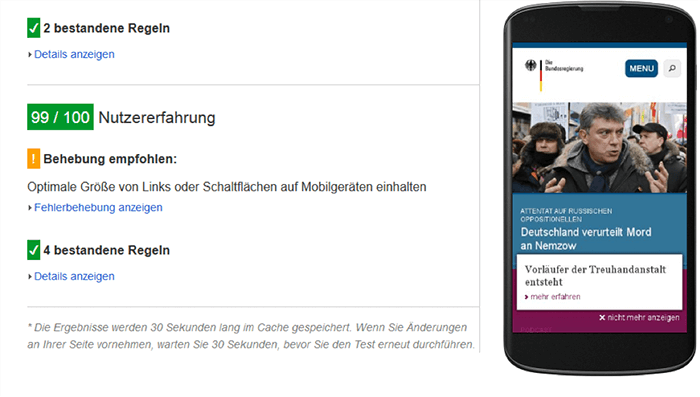

Wie schon bei den strukturierten Daten, gilt auch hier, die Fehler nochmal mit Hilfe des PageSpeed Insights Tool zu testen. Google Analysiert dabei den Code und berechnet die Leistung der Seite mit einer Punkte Skala von 0 bis 100, wobei 100 der Höchstwert ist.

Abbildung 18: Die Seite ist für Mobilgeräte optimiert

Das Tool kann übrigens mit jeder belieben URL genutzt werden, ihr braucht dafür keine Anmeldung bei der Google Search Console. Wer sich zum Beispiel ein Theme für seinen Blog oder CMS kaufen möchte, kann mit Hilfe dieses Tools einfach die Live-Preview Funktion des Themes nutzen, um zu sehen ob sich der Kauf auch wirklich lohnt.

Die Ansage von Google ist klar und deutlich: "Webmaster macht eure Seiten Mobile fähig!" Wer das noch nicht gemacht hat, sollte sich beeilen und das Tool dazu nutzen, zusammen mit der IT auf Mobile zu optimieren.

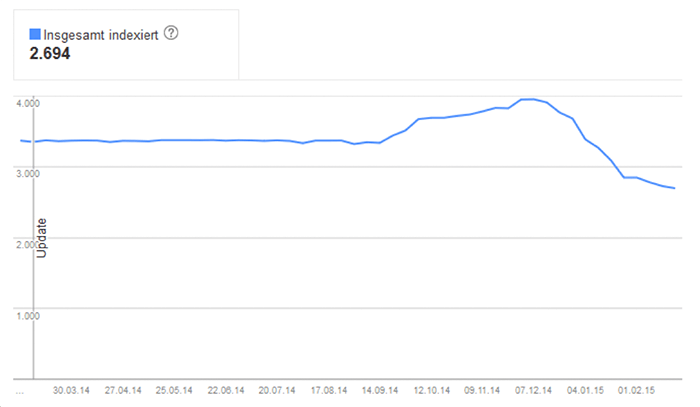

Indexierungsstatus

Wie viele URLs der eigenen Seite sind eigentlich im Google Index? Google beantwortet diese Frage mit Hilfe eines Diagramms.

Abbildung 19: Anzahl der von Google indexierten URLs

Die vertikale Linie mit dem Label Update zeigt übrigens die Umstellung der Google Search Console. Seit dem 9.3.2014 unterscheidet die GSC auch zwischen https und http. Es empfiehlt sich daher, immer alle Varianten einer Domain bei der Google Search Console anzumelden, um auf diese Weise zum Beispiel einer Duplicate Content Problematik auf die Spur zu kommen.

Falls sich die Anzahl der URLs ungewohnt stark verändert, sollte man sich auf Ursachenforschung begeben und zum Beispiel mit dem _site:domain.tld -inurl:_Verzeichnis Operator untersuchen, welche URLs sich im Index befinden.

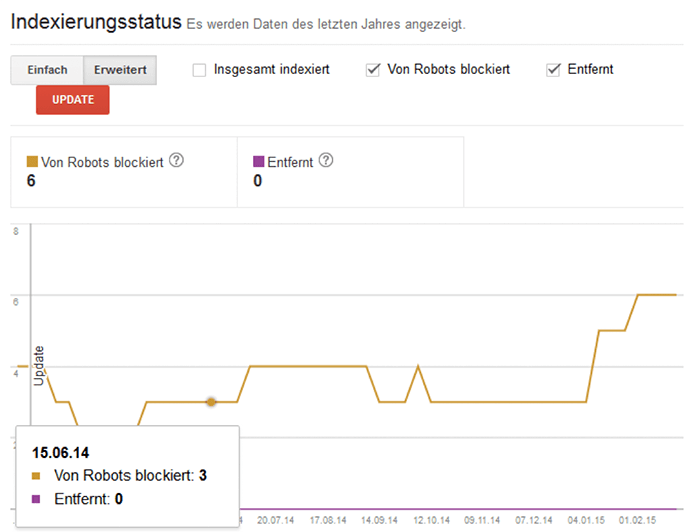

Für SEOs, die an mehreren Webseiten arbeiten, oder sich eine Domain zum ersten Mal angucken, wird die "Erweiterte Anzeige" sehr interessant sein. Hier sieht man nicht nur, wie viele URLs indexiert worden sind, sondern auch wie viele URLs über die Robots.txt gesperrt worden sind und wie viele URLs manuell entfernt wurden.

Abbildung 20: Erweiterter Indexierungsstatus

Mit Hilfe dieser Darstellung kann man zum Beispiel sehr gut herausfinden, wann eine fehlerhafte Robots.txt hochgeladen wurde (Anzahl der blockierten URLs steigt stark an). Google errechnet diese Kurve auf Wochenbasis. Wer also Veränderungen in der Anzahl der indexierten URLs erwartet, muss in der GSC mindestens eine Woche warten.

Alle Diagramme lassen sich herunterladen und mit wenigen Klicks in eine PowerPoint Präsentation einarbeiten, welche meistens recht überzeugend wirkt.

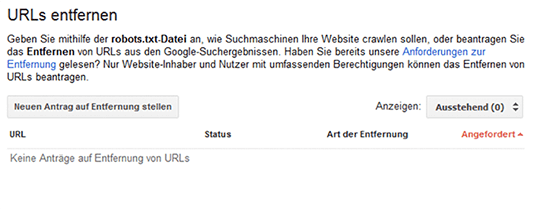

URLs entfernen

Wer eine ungewünschte URL im Index hat, kann über diese Funktion nicht nur die URL, sondern auch nur die Cache-Version dieser URL löschen. Besonders sinnvoll, wenn ein Inhalt in der Live-Version bereits korrigiert worden ist, aber Google den Cache nicht aktualisieren möchte.

Abbildung 21: URLs aus dem Google Index löschen

Abbildung 22: Nur den Cache einer URL löschen

Crawling Fehler

Fehlermeldungen sind keine gute User-Experience. Zwar kann man mit einer gut gemachten 404-Seiten versuchen die User auf der Seite zu halten, aber das sollte immer mehr die Ausnahme als die Regel sein. Aus diesem Grund bieten sich 301-Weiterleitungen immer sehr gut an, vorausgesetzt man hat eine passende Seite, auf die man in Zukunft weiterleiten kann.

Unter diesem Menüpunkt listet Google die Crawling Fehler auf, die der Googlebot beim Crawlen der Webseite gefunden hat:

Serverfehler (500er Status Code)

Soft 404 (200ok Status Code, aber kein Inhalt)

Zugriff verweigert (403)

Nicht gefunden (404)

Sonstiges

Google listet hier nur maximal 1.000 Fehler pro Fehlertype auf. Wer mehr hat, sollte daher die Verzeichnislogik aus den Suchanfragen verwenden, um das Limit zu umgehen und so noch weitere Fehler zu identifizieren. Auch hier gilt: Die Anzahl regelmäßig im Auge behalten und bei einem starken Anstieg auf Ursachenforschung gehen. Die Daten werden auf Tagesbasis erfasst, es bietet sich also an, unter der Woche öfters reinzugucken.

Die Funktion „Als korrigiert markieren“ ist nur eine optische Maßnahme. Fehler, die als erledigt markiert worden sind, können trotzdem immer wieder auftauchen. Wer komische URLs aufgelistet bekommt, die in dieser Form noch nie existiert haben, sollten sich keine Sorgen machen. Google „erfindet“ auch gerne URLs und probiert einfach mal irgendwelche Sachen aus. Ziel sollte es sein, die echten Fehler zu identifizieren und zu beheben. Die unwichtigen oder nicht existierenden Fehler kann man getrost ignorieren.

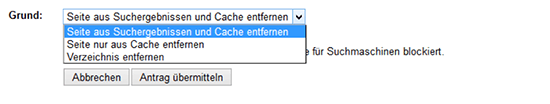

Robots.txt Tester

Wenn man eine URL oder ein Verzeichnis mit Hilfe der Robots.txt sperrt, verpufft die Linkpower (ähnlich wie beim internen nofollow). Darum sollte man sich immer gut überlegen, ob eine Sperrung eines Verzeichnisses via Robots.txt überhaupt sinnvoll ist, schließlich kann so wertvolle Linkpower dabei verloren gehen. Seit kurzem warnt Google auch davor JS-Dateien per Robots.txt zu sperren, die das Aussehen von Webseiten beeinflussen, denn dadurch kann Google die Seite nicht mehr ordnungsgemäß rendern und entsprechend bewerten.

Wer trotzdem Verzeichnisse über die Robots.txt sperren möchte, der kann dafür das Robots.txt Tester Tool verwenden. Mit diesem Tool kann man verschiedene Regeln ausprobieren und sehen, ob die gewünschten URLs auch wirklich wie gewünscht gesperrt werden.

Abbildung 23: Robots.txt testing Tool in der GSC

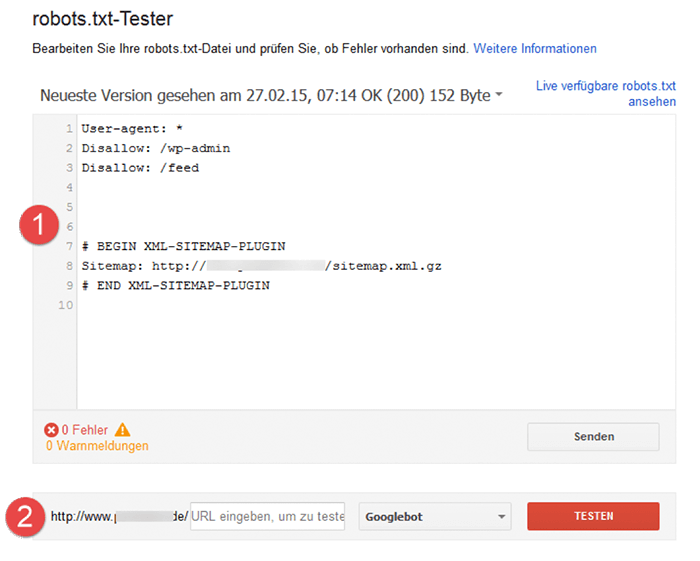

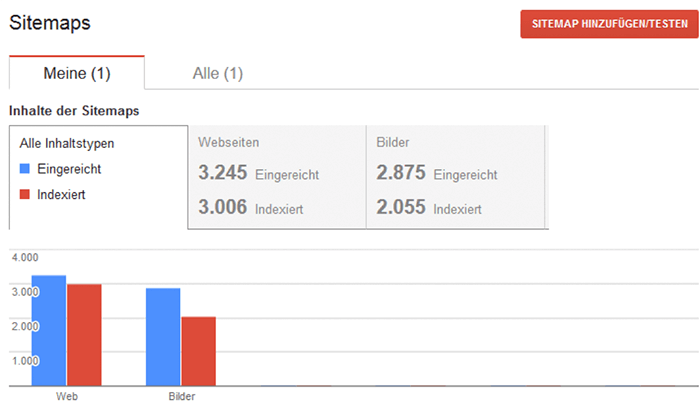

Sitemaps

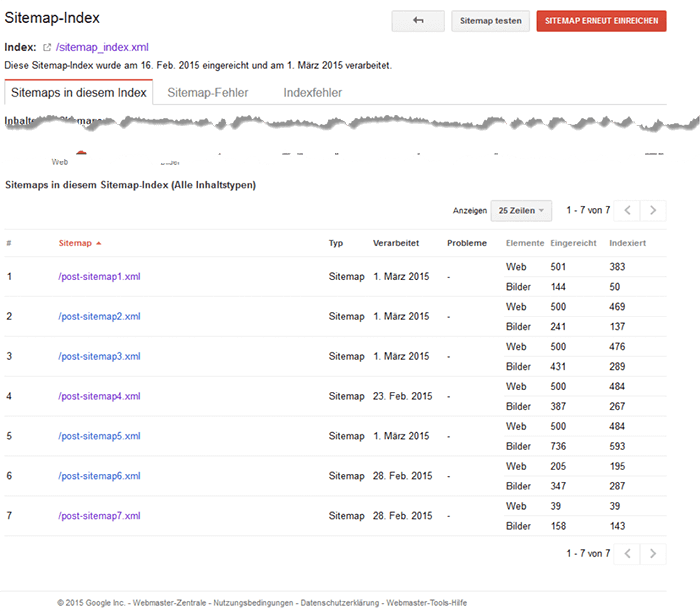

Die interne Verlinkung einer Seite sollte in der Regel so gut sein, dass keine weiteren Hilfsmittel wie zum Beispiel die Nutzung der Sitemap.xml nötig sind. Trotzdem ist es immer ratsam, eine Sitemap.xml zu nutzen. Auf der einen Seite fördert die XML Sitemap die Indexierung von URLs, auf der anderen Seite hat man durch die Google Search Console einen guten Überblick darüber, wie viele der eingereichten URLs wirklich im Index sind.

Abbildung 24: Eingereichten URLs vs. Indexierten URLs

Damit bei einer zu großen Abweichung die Ursachenforschung einfacher und schnell geht, sollte man versuchen, die Sitemaps möglichst gut zu segmentieren. Dies kann thematisch auf Kategorie-Ebene passieren oder man bildet die Verzeichnisstruktur der Seite ab. Besonders wichtig: Die Anzahl der enthaltenen URLs sollte nicht zu groß sein. Weist zum Beispiel eine Sitemap mit 400 URLs nur 100 indexierte URLs vor, kann man die 300 nicht indexierten URLs leicht identifizieren. Anders als wenn man eine Sitemap mit 50.000 URLs hat.

Damit man nicht jede Sitemap einzeln bei der GSC anmelden muss, sollte man auf Sitemap-Indexierungsdateien zurückgreifen. Dabei handelt es sich um eine Index Datei, in der alle Sitemaps aufgelistet sind. In der Google Search Console trägt man nur diese eine Datei. Die darin enthaltenen Sitemaps werden auf diese Weise automatisch mit eingetragen und können ab sofort in der GSC ausgewertet werden.

Abbildung 25: Sitemap-Index mit darin enthaltenen Sitemaps

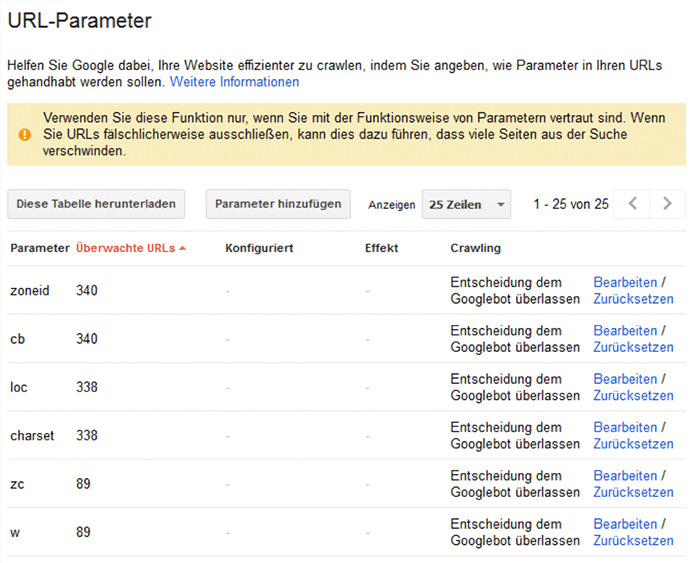

Parameter

Aus SEO Sicht sind URL-Parameter ein großes Problem, denn sie verursachen Duplicate Content. Zwar kann man dies mit Hilfe eines Canonical-Tags umgehen, aber der Googlebot muss die URL trotzdem analysieren. Dies verschlingt wertvolle Crawler Ressourcen. In der Google Search Console kann man Google eine Anweisung geben, wie der Googlebot mit den Parametern umgehen soll.

Abbildung 26: Parameter Handling in der GSC

Die Option, das Parameter Handling über die Google Search Console zu regeln wird immer wieder empfohlen, ist aber nicht die beste Lösung. Zum einen würde man Google nur sagen, wie man mit den Parametern umgehen soll und zum anderen ist dabei unklar, wie stark sich der Googlebot an diese Empfehlung hält. Es empfiehlt sich daher, aus der Google Search Console eine Liste der Parameter zu ziehen und dann zum Beispiel über Google Analytics zu analysieren, wie oft diese Parameter wirklich zum Einsatz kommen. Sobald diese Frage geklärt ist, kann man das Problem mit 301-Weiterleitungen oder anderen technischen Möglichkeiten lösen.

Nutzt die Google Search Console – es lohnt sich

Die Google Search Console ist ein mächtiges SEO Tool mit dem man zum Beispiel Suchbegriffe erhalten kann. Google versucht hier zwar, die Daten nicht zu transparent zu gestalten, aber mit ein paar Tricks wie einer ausführlichen Verzeichnisstruktur oder auch der Begrenzung des Zeitraums, kann man ziemlich viele und recht genaue Daten erhalten. Aber es geht nicht nur darum Daten zu exportieren, sondern auch darum die eigene Webseite im Blick zu haben. Wenn Google eine Benachrichtigung verschickt, ist das Problem meistens schon so dringend, dass kaum noch Zeit bleibt. Darum sollte man als SEO einen regelmäßigen Blick auf die GSC haben und frühzeitig Probleme erkennen.

Vereinfache Dein digitales Marketing mit nur einem Tool – der Ryte Software Suite.